☆딥러닝 공부를 위해서 꼭 읽어야 할 논문(사이트)들의 리스트를 정리해보고자한다.

순수히 개인적인 의견으로, 사용자의 관점에서 평가했다.

실제 AI 프로젝트를 진행할 때 도움이 되었던 논문들을 중심으로 우선순위를 작성했다.

* 지표 :

1. 논문의 중요성 : 마일드스톤, 인용, 중요저자 등

2. 실용성 : 실제 모델 개발 시, 활용도

* 참고사이트:

1. github.com/floodsung/Deep-Learning-Papers-Reading-Roadmap

2. github.com/terryum/awesome-deep-learning-papers

3. paperswithcode.com/sota/image-classification-on-imagenet

Papers with Code - ImageNet Benchmark (Image Classification)

The current state-of-the-art on ImageNet is Meta Pseudo Labels (EfficientNet-L2). See a full comparison of 239 papers with code.

paperswithcode.com

※ 내가 풀어야할 Task에 가장 적합한 논문이 무엇일까? 고민 될때, 가장 먼저 들어가보는 사이트 입니다.

중요한 논문들이 쏟아져 나오는 상황에서, 최소한에 의견공유? 정도로 생각해주시면 감사할거 같습니다.

[Benchmark Analysis of Representative Deep Neural Network Architectures - 2018]

- 딥러닝 Architecture 기본 -

[1] ImageNet Classification with Deep Convolutional Neural Networks(AlexNet) - 2012

https://proceedings.neurips.cc/paper/2012/file/c399862d3b9d6b76c8436e924a68c45b-Paper.pdf

종합 : ⭐⭐⭐

1. 논문 중요도 : 5점

2. 실용성 : 1점

설명 : AlexNet은 CNN의 시작이기 때문에, 쓸일은 없지만 많은 딥러닝에 많은 의의가 있는 논문

점수가 낮은 이유는.. 워낙초기의 논문이라, 시간이 없으신분은 블로그로 찾아서 보시는 정도로도 충분

- Local Response Normalization

[2] Going deeper with convolutions(Inception-v1) - 2014

종합 : ⭐⭐⭐⭐

1. 논문 중요도 : 5점

2. 실용성 : 3점

설명 : Inception module에 시작, 모델을 직접 구현해보면서 모델링 코딩을 연습하기에도 좋다.

- Inception module

- 1x1 Conv(Network in Network)

[3] Very Deep Convolutional Networks for Large-Scale Image Recognition

종합 : ⭐⭐⭐⭐

1. 논문 중요도 : 5점

2. 실용성 : 3점

설명 : Inception-v1 보다 성능이 낮아 2등을 했지만, 다른 딥러닝 Task의 Backbone으로 많이 사용(ResNet가 나오기 전까지)

- 3x3 CNN Block (간단하게 Archtecture를 구성해보자)

- 간단하게 구성된 Architecture의 중요성을 보여줬다고 생각한다.

더 좋은 성능이지만 모델 구조가 복잡했던, Inception-v1보다 더 적극적으로 사용된 것을 보면

[4] Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift (BN-Inception) - 2015

arxiv.org/pdf/1502.03167v3.pdf

종합 : ⭐⭐

1. 논문 중요도 : 3점

2. 실용성 : 2점

설명 : 다른 Task에서 BN-Inception이 나오는 경우가 있는데 이 논문이다.

Paperswithcode 사이트에서는 이 논문을 Inception V2라고 작성했지만,

BN-Inception으로 알고 계시는게 좋을거 같다.(필요할때만 읽자)

- Batch Normalization + inception module

[5] Rethinking the Inception Architecture for Computer Vision (Inception-v2~3) - 2016

arxiv.org/pdf/1512.00567v3.pdf

종합 : ⭐⭐⭐⭐⭐

1. 논문 중요도 : 5점

2. 실용성 : 5점

설명 : CNN모델의 구성에서, 많은 Insight를 주는 논문 중에 하나이다. 필수로 읽어야 되는 논문중에 하나.

- Factorization : 3x1 conv + 1x3 conv > 3x3 conv

- Grid Size Reduction : 2 stride를 적용

- Label Smoothing

[6] Deep Residual Learning for Image Recognition (ResNet) - 2015

arxiv.org/pdf/1512.03385v1.pdf

종합 : ⭐⭐⭐⭐⭐

1. 논문 중요도 : 5점

2. 실용성 : 5점

설명 : ResNet을 모르면, 이미지 분석을 할 수 없다. 간단하면서 창의적인 아이디어로, 아름다운 논문 중 하나이다.

- Residule learning ( + Bottleneck)

- VGG 처럼 간단하게 만들자

[7] Densely Connected Convolutional Networks (DenseNet) - 2017

arxiv.org/pdf/1608.06993v5.pdf

종합 : ⭐⭐⭐

1. 논문 중요도 : 3점

2. 실용성 : 4점

설명 : ResNet보다 적은파라미터로 높은 성능을 보여준다. Backbone으로 테스팅해볼 가치가 있는 모델

- 실용성이 높은 모델 중 하나

- 기본 아이디어를 이해하기가 쉬워서, 간단하게 리뷰정도로도 충분할 것으로 보인다.

[8] Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning - 2016

arxiv.org/pdf/1602.07261v2.pdf

종합 : ⭐⭐⭐⭐⭐

1. 논문 중요도 : 5점

2. 실용성 : 5점

설명 : ResNet + Inception. 성능이 높아, 속도보다는 성능이 우선될 때 테스팅하기 매우 좋은 Backbone

- 성능을 타겟으로 한 Task에서, 실용성이 매우 높은 모델 중 하나

- 코딩공부로 좋음(반대로, 짜기는 복잡한 Architecture)

- Inception 모델의 방점

[9] EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks(EfficientNet) - 2019

arxiv.org/pdf/1905.11946v5.pdf

종합 : ⭐⭐⭐⭐⭐

1. 논문 중요도 : 5점

2. 실용성 : 5점

설명 : 아름다운 논문 중 하나. 실용적인 모델을 중요시하는 사람으로서, 이 논문이 딥러닝에 기여하는 점이 크다.

- 실용성 갑중의 갑

- 모델의 성능 = resolution x depth x width → 세 구성요소의 최적의 비율을 찾음

- 꼭 읽어야될 논문 중 하나!

- 딥러닝 Architecture 심화 -

ResNet 계열

[1] Wide Residual Networks - 2016

arxiv.org/pdf/1605.07146v4.pdf

종합 : ⭐⭐

1. 논문 중요도 : 2점

2. 실용성 : 2점

설명 : Width 개념 - Channel의 수

- 정리해둔 리뷰만 봐도 기본 아이디어 이해가능

- ResNext 논문과 함께 개념을 정리하면서 읽으면 좋을듯

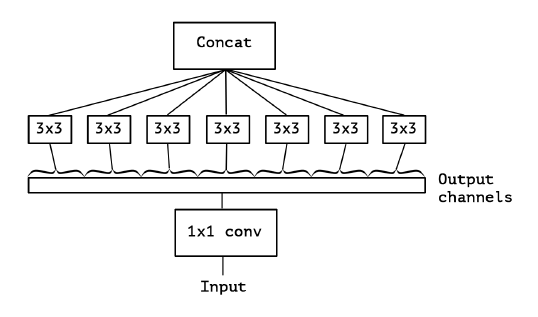

[2] Aggregated Residual Transformations for Deep Neural Networks (ResNext) - 2017

arxiv.org/pdf/1611.05431v2.pdf

종합 : ⭐⭐⭐⭐

1. 논문 중요도 : 4점

2. 실용성 : 4점

설명 : 모델의 height, width였던 기존의 구성에서, Cardinality 개념을 제안. 종종 테스트해보는 모델 중 하나

- Cardinality : Residual Block내에서 병렬로 구성되는 Grouped Conv의 개념

- Classification : Inception-ResNet-v2보다는 무거우면서 성능은 낮은편이라, 실용성에서는 조금은 애매하다.

- 하지만, 다른 Task(Object detection 등)에서 많이 쓰이는 Backbone으로 알아둘 필요성 높다.

Inception 계열

[1] Xception : Deep Learning with Depthwise Separable Convolutions - 2017

arxiv.org/pdf/1610.02357v3.pdf

종합 : ⭐⭐⭐

1. 논문 중요도 : 3점

2. 실용성 : 4점

설명 : Depthwise Conv를 활용한, 모델 경량(효율)화

- Depthwise Conv(=Separable Conv) : Input Channel에 대하여 독립(분리)적으로 연산함

- Cross-channel correlation(Channel)과 Spatial Corrlation(HxW)을 분리하여, 더 효율적으로 학습

- 기존의 Inception Module을 Depthwise Conv로 대체

- Active Learning -

[1] Active Learning for CNN : A Core-set Approach - 2018

종합 : ⭐⭐⭐⭐⭐

1. 논문 중요도 : 5점

2. 실용성 : 5점

설명 : 딥러닝 모델의 Feature를 직접활용하는 Active Learnig

- Task-agnostic(Task와 무관) ∵ CNN의 Feature를 활용

- 실용성 또한 높다 (단, 쉬운 알고리즘을 사용했을 때)

- End-to-End 학습이 아닌 것은 아쉬움

- kmhana.tistory.com/6?category=838050 참고

[2] Discriminative Active Learning(DAL)- 2019

종합 : ⭐⭐⭐⭐

1. 논문 중요도 : 5점

2. 실용성 : 4점

설명 : 복잡하지 않으면서, 재미있는 아이디어를 구현했다.

- Deep learning 모델의 Feature를 활용

- Binary Classifier(레이블링 여부)를 활용하여, Active Learning을 학습

- 블로그의 설명이 상세히 진행되어 참고할 만한 자료가 많습니다.

- 단, End-to-End 학습이 되지 않습니다.

- kmhana.tistory.com/12?category=838050 참고

[3] Learning Loss for Active Learning - 2019

종합 : ⭐⭐⭐⭐⭐

1. 논문 중요도 : 5점

2. 실용성 : 5점

설명 : 2019년도 제 기준 인상깊은 논문 중 하나 입니다.

- 딥러닝으로 학습 과정에서 End-to-End로 Active Leaning을 진행합니다.

- 굉장히 좋은 아이디어를 사용했습니다.

- 실용성도 좋습니다. Task에 무관(Task-agnostic)하며, AL을 위한 추가 Cost가 필요 없습니다.

- 단, Diversity관점에서는 약점이 있습니다.

- kmhana.tistory.com/10?category=838050 참고

- Metric Learning -

[1] MultiGrain: a unified image embedding for classes and instances - 2019

[2] Combination of Multiple Global Descriptors for Image Retrieval(CGD) - 2020

arxiv.org/pdf/1903.10663v4.pdf

종합 : ⭐⭐⭐⭐⭐

1. 논문 중요도 : 5점

2. 실용성 : 5점

설명 : 좋은 아이디어! 뛰어난 성능! 쉬운 구현! 3박자를 모두 갖춘 Metric Learning의 핵심 논문

- 여러 Global Descriptors들을 앙상블 했더니, Image Retrival 성능이 좋았다.

- 모델을 효과적이면서 End-to-End로 학습하면서, 앙상블(Ensemble)의 효과를 구현한 논문!!

- Classification Loss + Triplet Loss + Multipl Global Descriptors의 삼중연

- 구현도 쉬운데, 성능도 뛰어나다면, 쓰지 않을 이유가 없다.

딥러닝을 위한 기본

1. neuralnetworksanddeeplearning.com/index.html

Neural networks and deep learning

neuralnetworksanddeeplearning.com

설명 : 딥러닝 기본에 대해서, 너무 재밌게 잘 적어주셨다.

딥러닝 기본에 대해서 공부하고 싶다면, 이 사이트만봐도 기본을 알 수 있다고 생각한다.

딥러닝 기본을 위한 첫단계로 부족함이 없다.

'딥러닝을 위한 > 가이드(Guide)' 카테고리의 다른 글

| [논문요약] Transformer 등장 - Attention Is All You Need(2017) ② (0) | 2021.08.03 |

|---|---|

| [논문요약] Transformer 등장 - Attention Is All You Need(2017) ① (4) | 2021.07.27 |

| [논문요약] Classification 학습방법 - Bag of Tricks(2018) (1) | 2021.04.01 |