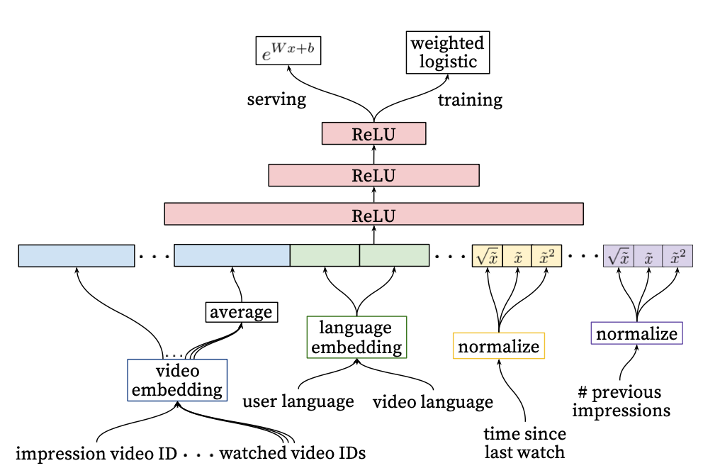

"데이터 사이언티스트 하지 마세요" 반론과 비판 2탄에 이어서, 3탄을 이어서 이야기해 보고자 합니다. "데이터 사이언티스트 하지 마세요"를 요약하자면 다음과 같습니다. 1. 대부분의 회사에서는 데이터가 없다. 즉 머신러닝만으로 성과를 낼 환경이 부족하다. - 로그를 직접 남기거나 백앤드 개발자를 설득해야 하므로 업무의 진행 속도가 느리다. 2. 신입이나 학부 졸업만으로는 성과 내기 어렵다. - 석·박사보다 성과를 내기 어렵기에, 신입을 잘 뽑지 않는다. - AI 프로젝트에서 모델링은 5% 정도다.. (그에 비해, 요즘 학부생들이 머신러닝에만 관심이 높다) 3. 백앤드로 시작해야 한다. - 백앤드가 수요가 더 높고 연봉도 높다. - 백앤드에서 데이터 엔지니어링으로 가기 쉬우며, 백앤드에서 머신러닝으로 가..